- La terza ondata dell’Intelligenza Artificiale sta provocando una rivoluzione socioeconomica con forti impatti sul mondo del lavoro. Organizzazioni come il Darpa stanno sviluppando tecnologie come l’Explainable AI (XAI) per migliorare la trasparenza e la comprensibilità delle IA.

- Nonostante i progressi, l’IA ha attraversato periodi di delusione e richiede ancora sforzi multidisciplinari per risolvere problemi complessi e gestire grandi quantità di dati.

- Tuttavia, comporta rischi come la perdita di posti di lavoro e il controllo delle decisioni automatiche. Per mitigare questi rischi, è necessario che i governi sviluppino politiche di welfare e regolamentazioni, come l’AI ACT dell’UE, che classifica i rischi associati all’IA.

I recenti sviluppi della terza ondata dell’Intelligenza Artificiale (IA) dimostrano come questa disciplina stia già provocando una nuova rivoluzione socioeconomica, con forti impatti anche sul mondo del lavoro.

Il dibattito in corso mostra come, a fronte di una serie di evidenti vantaggi, stiano emergendo molti problemi di carattere sociale ed etico, a cui i vari governi, le istituzioni sovranazionali, le componenti sociali e il mondo scientifico stanno cercando di dare delle risposte.

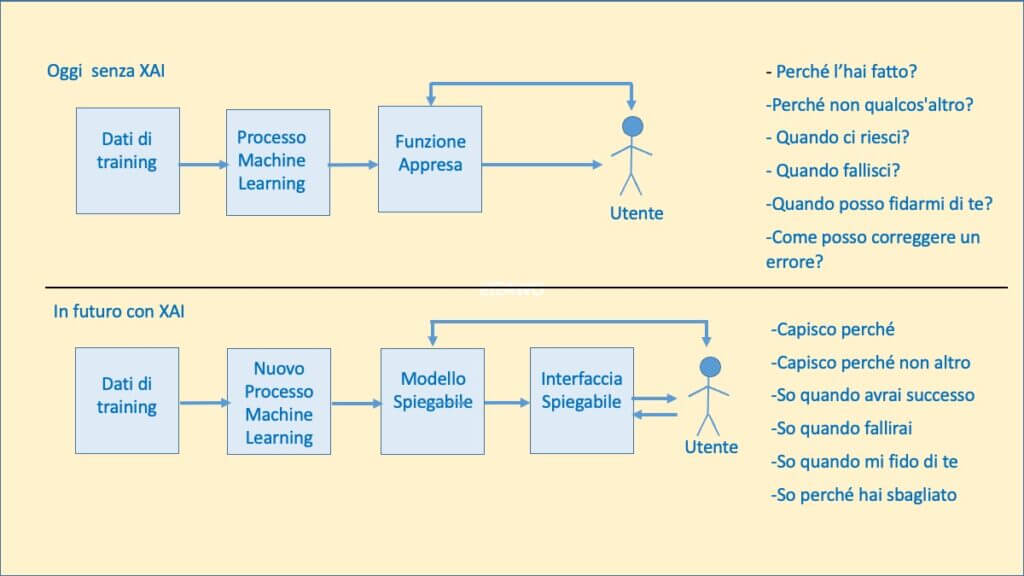

Uno di questi problemi è che l’utente (ma in certi casi lo stesso progettista) non è in grado di valutare i criteri e l’affidabilità delle decisioni/azioni assunte da un sistema/applicazione IA (S-IA). Per rispondere a tale problema da tempo varie organizzazioni, ma in particolare dal 2017 il Darpa (Defense Advanced Research Projects Agengy) del governo USA, stanno considerando la tecnologia XAI (Explainable AI) che si propone proprio di rendere consapevole l’utente di come opera un S-AI, ovvero di dare un valore concreto all’IA Spiegabile.

Indice degli argomenti

L’evoluzione dell’IA

Da millenni l’uomo cerca di costruire macchine che in modo automatico svolgono delle attività, cosi come cerca di comprendere e rappresentare il funzionamento del comportamento e del pensiero umano.

Il primo lavoro sull’IA che di solito viene citato è stato quello della progettazione di una rete neurale fatta nel 1943 da Warren McCulloch e Walter Pitt, anche se nel 1936 fu Alain Turing con la sua “macchina” a proporre un modello di calcolatore automatico. Sempre Turing nel 1950, nell’articolo Computing Machinery and Intelligence, affrontò il tema dell’intelligenza di una macchina suggerendo il suo famoso test basato sul colloquio via telescrivente tra una persona umana e un calcolatore che si “comporta in maniera umana” (approccio cosiddetto “comportamentista”).

Tuttavia fu solo nel 1956 che John McCarthy propose il nome Artificial Intelligence, in un seminario a Dartmouth, lanciando così la sfida ambiziosa della possibilità di costruire una macchina che potesse operare come il cervello umano.

Da questo momento in poi è stato tutto un fiorire di studi con dei risultati che hanno portato alla realizzazione di linguaggi di programmazione logica come il Lisp e Prolog, e a innovativi metodi e algoritmi (tra cui quelli cosiddetti genetici, ossia programmi capaci di modificarsi automaticamente migliorando le proprie prestazioni) creando una vera e propria disciplina dell’IA.

Dal punto di vista applicativo ci sono esempi in numerosi campi (diagnostica, giochi, finanza, virtual assistance, guida autonoma, robotica, e altri), ma il loro numero è destinato a crescere fino a coinvolgere tutti i settori socioeconomici: l’IA va considerata a tutti gli effetti come una nuova tecnologia “general purpose”. Secondo PwC, l’IA potrebbe contribuire fino a 15.700 miliardi di dollari all’economia globale entro il 2030.

Va detto anche che se oggi i risultati della R&S sull’IA sono molto promettenti e i sistemi in grado di autoapprendere e agire in autonomia senza l’intervento umano sono una realtà, in passato essi hanno avuto un andamento altalenante, con periodi di grande successi seguiti da significative delusioni: il primo periodo negativo fu il cosiddeto “inverno IA” 1974-1980, che comportò una drastica riduzione della spesa in R&S. Le ragioni di tale andamento, che in parte ancora permangono, sono state essenzialmente tre:

- Complessità dei problemi da risolvere, e quindi necessità di un grande sforzo di R&S multidiscliplinare;

- Necessità di disporre di sistemi di elaborazioni sempre più potenti;

- Necessità di disporre di enormi quantità di dati reali su cui far operare un S-IA.

In merito al primo punto, l’obiettivo indicato a Dartmouth di creare una macchina capace di ragionare simulando il cervello umano ( approccio “connessionistico” o IA Forte) era scientificamente molto ambizioso, anche perché richiedeva il superamento delle criticità 2) e 3). Uno dei problemi dello sviluppo dell’IA nei primi decenni di vita è stato quello di studiarla molto come una problematica da Computer Science e ICT senza un forte sforzo sinergico con altri ambiti che interessano l’IA: Matematica, Neuroscienze, Filosofia, Linguistica, Biologia, Psicologia, Sociologia.

A fronte delle difficoltà con l’IA Forte ci sono stati anni in cui alcuni hanno deciso di seguire un approccio basato sull’emulazione del cervello umano (approccio “comportamentistico” o IA Debole, a cui di fatto si rifaceva Turing), ottenendo risultati di buona utilità applicativa (vedi i Sistemi Esperti, Virtual Assistant, sistemi per giochi…).

Certamente lo sviluppo del Machine Learning (ML) basato sul Deep Learning, ovvero su reti neurali profonde che fanno uso di metodi di backpropagation, ha dato un grande impluso all’approccio “connessionistico”. Oggi siamo in una fase di forte entusiasmo sostenuta da una crescita continua della potenza di calcolo dei sistemi di elaborazione (con le potenti GPPGPU-General Purpose Graphics Processing Unit si è arrivati già a costruire supercomputer da Exaflops) e dalla disponibilità di informazioni digitalizzate prodotte sopratutto dall’Internt of Things (IoT). Sull’onda di questo entusiasmo c’è chi pensa che fatta una macchina che ragiona come il cervello umano la si possa anche migliorare in modo da essere superiore, ovvero superintelligente. In questo senso si dice che oggi l’IA forte è formata da due aree di ricerca: AGI ( Artificial General Intelligence), ASI (Artificial Super Intelligence).

Al di là che molti, come Federico Faggin, ritengono lontano e praticamente impossibile con una macchina elettronica dotata di software, che di fatto tratta legami sintattici e non contenuti semantici, creare un S-IA che simuli completamente il cervello umano e che abbia una “coscienza”, c’è però da essere consapevoli che un singolo S-IA può essere più performante di un essere umano in compiti specifichi.

Benefici e rischi dell’IA

Come già accennato, lo sviluppo dell’IA sta ponendo molte domande sui suoi benefici e rischi. Per quanto riguarda i primi, sono ormai evidenti e importanti. In generale essi vanno nella direzione di trasferire alle macchine faticose e ripetitive attività umane fisiche (un esempio sono i robot dotati di IA) e cognitive (tediose sequenze di calcolo o sorveglianza/controllo del corretto funzionamento di macchine) rendendole più efficienti e sicure (si pensi alla guida autonoma), ma anche nella possibilità di realizzare nuovi servizi (si pensi alla telemedicina e all’assistenza alla persona) e nuove idee che portano a nuove innovazioni.

I problemi o i rischi in sintesi riguardano:

- la sostituzione dell’uomo in molti lavori (tipicamente quelli poco manuali) con conseguenti ricadute negative sull’occupazione (l’ultimo report di Goldman Sachs prevede che l’IA generativa comporterà una perdita di 300 milioni di posti di lavoro);

- la difficoltà a mantenere il controllo delle decisioni/azioni/raccomandazioni di un S-IA in termini di equità e correttezza, al fine anche di individuare quelle, a volte volutamente false, prodotte per condizionare le scelte/convinzioni delle persone e la vita democratica.

Per far fronte a questi rischi, come sempre è accaduto per le rivoluzioni tecnologiche, è necessario che i governi, con il coinvolgimento dei vari attori, mettano in campo azioni affinché la transizione dal vecchio contesto socioecnomico al nuovo sia socialmente accettabile, rispetti i diritti delle persone e porti a un nuovo benessere collettivo.

Per i problemi occupazionali è importante che i governi elaborino idonee politiche di welfare e favoriscano la nascita di nuovi lavori investendo anche sulla formazione dei lavoratori.

Per quelli etici, si possono creare appositi codici di condotta (si parla anche di algoretica) e qualificare i produttori di applicazioni. Allo stato tutte queste problematiche sono all’attenzione delle istituzioni pubbliche e private del mondo sviluppato che hanno già assunto varie iniziative.

Dopo la diffusione di sistemi di IA Generativa, come Chat GPT-4 di Open AI e Bard di Google, la discussione sui rischi dell’IA si è particolarmente animata e alcuni autorevoli attori stanno auspicando una pausa di riflessione. Il parlamento Ue, sulla scia del GDPR, ha affrontato il problema ed ha approvato di recente l’AI ACT che adesso proseguirà il suo iter legislativo finale. I pilastri di tale AI ACT sono i livelli di rischio (minimo, limitato, elevato e inaccettabile) a cui corrispondono obblighi normativi diversi. Tuttavia la strada resta ancora in salita e riflette le difficoltà che sinora si sono avute con Internet e i Social Media: uno sviluppo molto rapido, dall’impatto socioeconomico e democratico enorme, che i governi non sono riusciti a seguire con la giusta comprensione e velocità, e che pertanto si è sviluppato senza molte regole e standard tecnici.

La via dell’XAI

Da alcuni anni per risolvere il problema dei rischi legati all’impiego dell’IA oltre a definire regole specifiche è in atto anche uno sforzo di R&S per mettere a punto tecniche per realizzare la cosiddetta Human Centered AI, ovvero l’adozione di metodi che pongono al centro le esigenze delle persone e della società in cui vivono. Una di queste è l’XAI (termine coniato da Van Lent nel 2004) che ha lo scopo di consentire all’utente di conoscere come un S-IA arriva alle sue decisioni/azioni/raccomandazioni e come si comporterà in futuro. Un tema diventato di grande importanza con lo sviluppo del ML ed in particolare del Deep Learning che di fatto costituisce un approccio black-box basato su modelli complessi con elevato numero di connessioni e nodi.

In un certo senso l’XAI punta anche a realizzare l’Human-in the-Loop, in modo da bilanciare il fatto che un S-IA sia più capace del singolo essere umano nell’ambito applicativo specifico (si pensi, ad esempio, a quanto può essere rilevante una certa opacità di un S-IA in campo medico sanitario o militare). Il Darpa ha definito l’IA spiegabile come un S-IA in grado di spiegare la sua logica a un utente umano, caratterizzare i suoi punti di forza e di debolezza e trasmettere una comprensione di come si comporterà in futuro.

Messa così è evidente che la spiegabilità comprende anche la l’interpretabilità, la comprensibilità, la correttezza del processo e la trasparenza. E’ evidente che tutto questo richiede che il team di progettazione deve tener anche conto della natura multidisclipinare dell’IA ed in particolare della psicologia umana della spiegazione che attinge al vasto campo di ricerca delle scienze sociali: per spiegare una cosa si deve tener conto del livello di comprensione dell’interlocutore e delle sue finalità. La stessa interfaccia HCI (Human computer Interface) deve essere evoluta e considerare la voce, l’espressione facciale/gestuale…

Allo stato si stanno sperimentando molte tecniche per l’XAI prodotte da varie Università e centri di ricerca pubblici e privati. Gli studi del Darpa conclusisi a fine 2021 hanno analizzato molte tecniche mettendo a fuoco i vari problemi ancora da risolvere.

Il modello (concept) considerato dal programma Darpa per lo sviluppo dell’XAI è quello illustrato nella figura sottostante

(elaborazione da https://www.darpa.mil/program/explainable-artificial-intelligence)

Tra le difficoltà emerse ci sono quelle di fornire spiegazioni personalizzate al tipo di utente, mantenere alte le prestazioni e, soprattutto, valutare la qualità delle prestazioni di “spiegabilità” che come detto in precedenza comprende vari aspetti. La strada intrapresa, dunque, richiede ancora un lavoro di R&S e pur non risolvendo tutti i problemi sul tappeto rappresenta un importante passo avanti sul futuro dell’IA.

Considerazioni finali

I sistemi IA autonomi sono ormai una realtà in continuo sviluppo che stanno rivoluzionando la nostra società. Una rivoluzione a cui, come è avvenuto altre volte nella storia dell’uomo, non ci si può e deve opporre ma bisogna governare per sfruttare al meglio i suoi benefici e minimizzare gli effetti negativi. Fanno bene i governi a mettere in campo opportune azioni regolatorie e politiche idonee per accompagnare la conseguente trasformazione socioecomica, anche se è un compito difficile

In questo contesto lo sviluppo dell’XAI appare una soluzione tecnologica efficace per risolvere il problema principale dell’opacità dei nuovi S-IA in termini di comprensione, trasparenza, correttezza delle decisioni/azioni/raccomandazioni, perseguendo anche l’obiettivo dell’Human Centered AI con l’uomo che entra nel Loop. Si tratta di una necessaria sfida per la R&S di settore a cui tutti gli attori in campo devono contribuire.