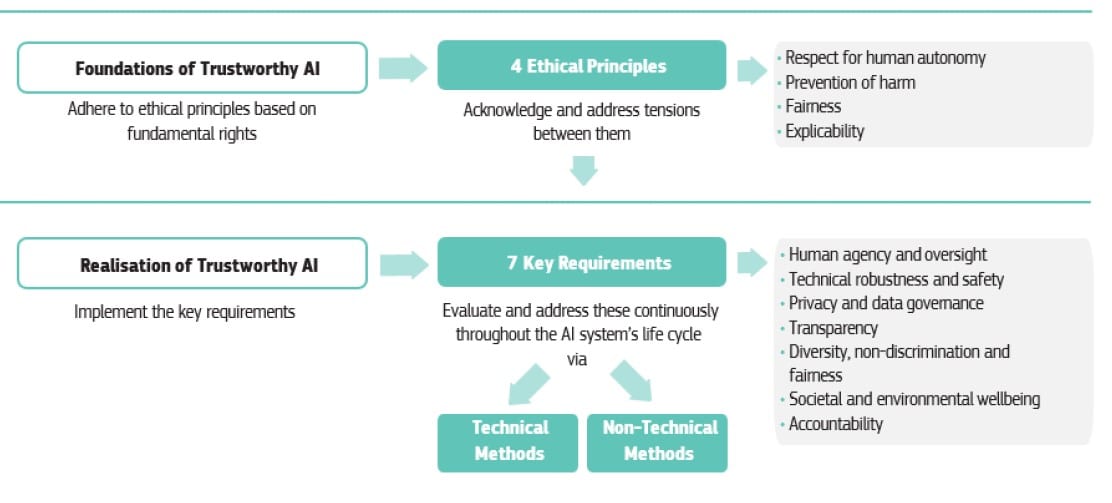

Rispetto dell’autonomia umana, prevenzione del danno, equità ed esplicabilità dei sistemi, del loro funzionamento, dei loro effetti. Sono i quattro principi fondamentali alla base delle linee guida etiche per promuovere e realizzare un’Intelligenza artificiale che sappia meritarsi la nostra fiducia (Trustworthy Artificial Intelligence). Queste linee guida sono state elaborate dal gruppo europeo indipendente di esperti di alto livello, composto da 52 membri internazionali, tra cui 5 italiani, presentate in occasione del Digital Day 2019, che si è svolto il 9 aprile a Bruxelles.

L’Intelligenza artificiale promette di avere un forte impatto sul futuro dell’uomo, e su gran parte delle sue attività, dalla salute, alla ricerca, al clima, innovazione tecnologica e lavoro, sicurezza e infrastrutture, mondo economico e finanziario, e molto altro ancora.

Per questo risulta fondamentale sviluppare una IA che sia Trustworthy, affidabile o, meglio ancora, meritevole di fiducia, perché gli stessi sistemi e strumenti Hi-Tech potranno portare vantaggi importanti o danni ingenti. Tutto dipenderà da come l’Intelligenza artificiale verrà programmata, diffusa, utilizzata.

Il primo passo europeo comune in questa direzione risale al Digital Day 2018, lo scorso aprile, quando la Commissione Ue istituì il gruppo di esperti di alto livello sull’intelligenza artificiale, con l’incarico di elaborare due progetti: gli Orientamenti etici sull’AI, presentati al Digital Day 2019, e le Raccomandazioni politiche e di investimento in questi ambiti.

Una prima bozza delle linee guida etiche è stata presentata e resa nota già lo scorso dicembre, per poi essere discussa pubblicamente, raccogliendo le osservazioni e il contributo di esperti e specialisti di vari settori, dal mondo accademico a quello delle imprese, per arrivare alla versione presentata oggi.

Più in generale, in un’IA “degna di fiducia” ci sono tre requisiti che dovrebbero essere sempre soddisfatti durante l’intero ciclo di vita del sistema. Uno: deve essere legale, conforme a tutte le leggi e i regolamenti applicabili. Due: deve essere etica, garantendo l’adesione a principi e valori, basandosi su un approccio fondato sui diritti fondamentali. Ed è proprio su questo punto che andranno a incidere le linee guida etiche. E tre: deve essere solida, sia da un punto di vista tecnico che di impatto sociale, poiché, anche con buone intenzioni, i sistemi di IA possono anche causare danni involontari.

Ognuno di questi tre requisiti di per sé è necessario ma non sufficiente per il raggiungimento di un’IA di cui ci si possa fidare. Idealmente, tutti e tre i componenti lavorano in armonia e si sovrappongono nel loro funzionamento. Ma se, in pratica, sorgono tensioni tra queste componenti, la società dovrebbe cercare di allinearle.

Ma ecco, più nel dettaglio, i quattro principi etici fondamentali che dovrebbero ispirare e permeare ogni futura applicazione di Artificial intelligence. Almeno in Europa.

Indice degli argomenti

Il principio del rispetto dell’autonomia umana

I diritti fondamentali su cui si fonda l’Unione europea puntano a garantire il rispetto della libertà e dell’autonomia degli esseri umani, “e questi principi dovranno essere difesi e rispettati anche nello sviluppo e poi nell’utilizzo di sistemi di Intelligenza artificiale”, prevede il primo punto delle linee guida etiche. In pratica, i sistemi di IA non devono subordinare, costringere, ingannare, manipolare, condizionare o gestire in modo ingiustificato gli esseri umani. Al contrario, essi dovrebbero essere progettati per aumentare, integrare e potenziare le capacità cognitive, sociali e culturali dell’uomo.

L’organizzazione delle funzioni tra esseri umani e sistemi di IA dovrebbe anche seguire i principi di progettazione e sviluppo umano-centrico, e lasciare un’opportunità significativa per la scelta umana: ciò significa assicurare la supervisione umana sui processi operativi nei sistemi di IA.

Il principio della prevenzione del danno

I sistemi di Artificial intelligence non devono causare danni o comunque incidere negativamente sugli esseri umani. Ciò comporta la tutela della dignità umana e dell’integrità fisica e mentale. I sistemi di IA e gli ambienti in cui operano devono essere sicuri e protetti, devono essere tecnicamente robusti e si deve garantire che non siano aperti a un uso doloso.

“Occorre poi prestare particolare attenzione”, ammoniscono le linee guida, “alle situazioni in cui i sistemi di IA possono causare o aggravare gli impatti negativi dovuti ad asimmetrie di potere o di informazione, ad esempio tra governi e cittadini, aziende e consumatori, datori di lavoro e dipendenti. La prevenzione dei danni implica anche la tutela dell’ambiente naturale e di tutti gli esseri viventi”.

Il principio di equità

“Lo sviluppo, la diffusione e l’uso dei sistemi di IA devono essere equi. Pur riconoscendo che esistono molte interpretazioni diverse dell’equità, riteniamo che l’equità abbia una dimensione sia sostanziale che procedurale. La dimensione sostanziale implica un impegno a: assicurare una distribuzione equa dei benefici e dei costi, e a garantire che gli individui e i gruppi siano liberi da pregiudizi, discriminazioni e stigmatizzazioni ingiuste”, rimarca il gruppo indipendente di esperti, nelle sue linee guida.

Dovrebbero essere promosse anche le pari opportunità in termini di accesso all’istruzione, ai beni, ai servizi e alla tecnologia. Inoltre, l’uso dei sistemi di IA non dovrebbe mai portare a ingannare o danneggiare la libertà di scelta delle persone.

Il principio di esplicabilità

“L’Esplicabilità è fondamentale per costruire e mantenere la fiducia degli utenti nei sistemi AI. Ciò significa che i processi devono essere trasparenti, le capacità e lo scopo dei sistemi di IA comunicati apertamente e le decisioni, per quanto possibile, spiegabili a coloro che ne sono direttamente o indirettamente interessati. Senza queste informazioni, una decisione non può essere debitamente contestata”, rilevano gli esperti di AI.

Non è sempre possibile spiegare perché un modello ha generato un particolare output o decisione (e quale combinazione di fattori di input vi ha contribuito). Questi casi richiedono un’attenzione particolare: in queste circostanze, possono essere necessarie altre misure esplicite (ad esempio, tracciabilità, verificabilità e comunicazione trasparente sulle capacità del sistema), a condizione che il sistema nel suo complesso rispetti i diritti fondamentali.

In estate un progetto pilota

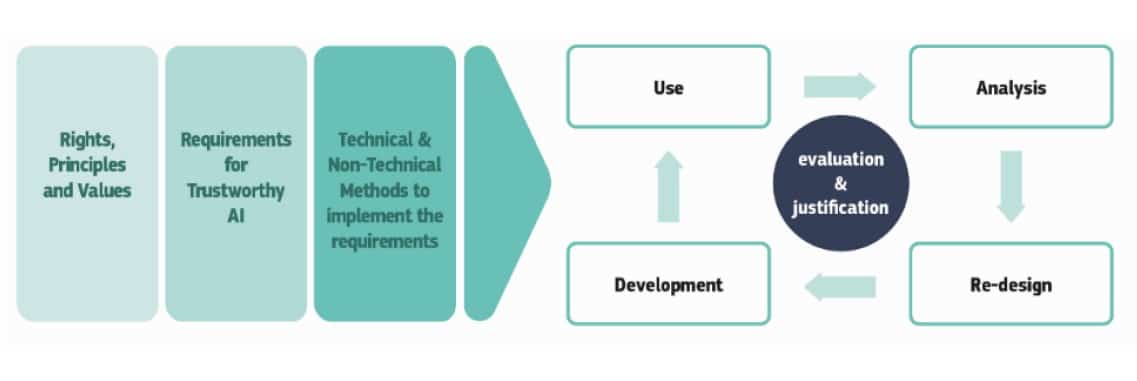

Se queste linee guida puntano a offrire una guida per le applicazioni di IA in generale, costruendo una base orizzontale per ottenere un’IA affidabile, situazioni diverse pongono sfide diverse: si dovrebbe quindi anche valutare se, oltre a questo quadro orizzontale, sia necessario un approccio settoriale, data la specificità del contesto dei sistemi di IA.

“Queste linee guida non intendono sostituire alcuna forma di politica o regolamentazione attuale o futura, né intendono scoraggiarne l’introduzione”, sottolineano gli esperti incaricati dalla Commissione Ue. Che rimarcano: “dovrebbero essere viste come un documento operativo da rivedere e aggiornare nel tempo, per garantire la loro continua rilevanza con l’evolversi della tecnologia, dei nostri ambienti sociali e delle nostre conoscenze. Questo documento è un punto di partenza per la discussione su un’intelligenza artificiale affidabile per l’Europa”, E, al di là dell’Europa, le linee guida puntano anche a promuovere la ricerca, la riflessione e la discussione su un quadro etico per i sistemi di IA a livello globale.

Nell’estate prossima, la Commissione europea avvierà una fase pilota di sviluppo e applicazioni concrete di Intelligenza artificiale affidabile su vasta scala, che coinvolgerà un’ampia gamma di attori: già oggi aziende, amministrazioni pubbliche e organizzazioni possono iscriversi all’Alleanza europea per l’AI e ricevere aggiornamenti sull’avvio della fase pilota. Che proseguirà fino all’inizio del 2020, quando il gruppo europeo di esperti sull’IA esaminerà riscontri e Feedback ricevuti da parte degli operatori coinvolti, e sulla base di queste esperienze la Commissione valuterà i risultati e proporrà eventuali passi successivi. La strada verso l’Intelligenza artificiale affidabile è appena iniziata, ma promette di portare lontano.

Gli altri progetti avviati nel Digital Day 2019

Il Digital Day 2019 ha messo insieme istituzioni europee, partner dell’industria, del mondo accademico e della società civile per far avanzare le cooperazione tecnologica su tre settori in particolare: digitalizzazione del patrimonio culturale europeo, sviluppo di un’agricoltura intelligente e sostenibile, e maggiore partecipazione delle donne al mondo digitale. Tre ambiti sui quali gli Stati dell’Ue hanno firmato una dichiarazione di progetto e lavoro comune.

“I nuovi impegni assunti oggi stanno consolidando gli sforzi degli Stati membri verso un’Europa digitale più competitiva e inclusiva”, sottolinea Andrus Ansip, vicepresidente della commissione Ue per il mercato unico digitale. Che fa notare: “una cooperazione rafforzata per sfruttare le tecnologie digitali può contribuire a far fronte a importanti sfide economiche, sociali, climatiche e ambientali”.